Лінейны дыскрымінантны аналіз

Лінейны дыскрымінантны аналіз (англ.: Linear discriminant analysis, LDA), нармальны дыскрымінантны аналіз (англ.: Normal discriminant analysis, NDA), або аналіз дыскрымінантнай функцыі (англ.: Discriminant function analysis) — абагульненне лінейнага дыскрымінанта Фішэра, метаду, які выкарыстоўваецца ў статыстыцы і іншых навуках, каб знайсці лінейную камбінацыю прыкмет, якая характарызуе або падзяляе два ці больш класы аб’ектаў або падзей. Атрыманая камбінацыя можа выкарыстоўвацца ў якасці лінейнага класіфікатара або, часцей, для зніжэння памернасці перад наступнай класіфікацыяй.

LDA цесна звязаны з дысперсійным аналізам (ANOVA) і рэгрэсійным аналізам, якія таксама спрабуюць выразіць адну залежную зменную як лінейную камбінацыю іншых прыкмет або вымярэнняў[1][2]. Аднак ANOVA выкарыстоўвае катэгарыяльныя незалежныя зменныя і непарыўную залежную зменную, у той час як дыскрымінантны аналіз мае непарыўныя незалежныя зменныя і катэгарыяльную залежную зменную (г.зн. метку класа)[3]. Лагістычная рэгрэсія і пробіт рэгрэсія больш падобныя да LDA, чым ANOVA, бо яны таксама тлумачаць катэгарыяльную зменную значэннямі непарыўных незалежных зменных. Гэтым метадам аддаецца перавага, калі нельга меркаваць, што незалежныя зменныя маюць нармальнае размеркаванне, што з’яўляецца фундаментальным дапушчэннем метаду LDA.

LDA таксама цесна звязаны з метадам галоўных кампанентаў (PCA) і фактарным аналізам у тым, што яны ўсе шукаюць лінейныя камбінацыі зменных, якія лепш за ўсё тлумачаць даныя[4]. LDA відавочна спрабуе змадэляваць розніцу паміж класамі даных. PCA, наадварот, не ўлічвае ніякай розніцы ў класе, а фактарны аналіз стварае камбінацыі прыкмет на аснове адрозненняў, а не падабенстваў. Дыскрымінантны аналіз таксама адрозніваецца ад фактарнага аналізу тым, што ён не з’яўляецца метадам узаемазалежнасці: неабходна адрозніваць незалежныя зменныя і залежныя зменныя (таксама называныя крытэрыяльнымі зменнымі).

LDA працуе, калі вымярэнні незалежных зменных для кожнага назірання прадстаўлены непарыўнымі велічынямі. Адпаведная методыка пры працы з катэгарыяльнымі незалежнымі зменнымі — дыскрымінантны аналіз адпаведнасці[5][6].

Дыскрымінантны аналіз выкарыстоўваецца, калі групы вядомыя апрыёры (у адрозненне ад кластарнага аналізу). Кожны выпадак павінен мець ацэнку аднаго або некалькіх колькасных прэдыктыўных вымярэнняў і ацэнку групавога вымярэння[7]. Кажучы простымі словамі, аналіз дыскрымінантнай функцыі гэта класіфікацыя — акт размеркавання рэчаў на групы, класы або катэгорыі аднаго тыпу.

Гісторыя[правіць | правіць зыходнік]

Арыгінальны дыхатамічны дыскрымінантны аналіз быў распрацаваны Рональдам Фішэрам у 1936 годзе[8]. Ён адрозніваецца ад ANOVA і MANOVA, якія выкарыстоўваюцца для прагназавання адной (ANOVA) або некалькіх (MANOVA) непарыўных залежных зменных паводле адной або некалькіх незалежных катэгарыяльных зменных. Аналіз дыскрымінантнай функцыі карысны для вызначэння таго, ці эфектыўны набор зменных для прагназавання прыналежнасці да катэгорыі[9].

Дапушчэнні[правіць | правіць зыходнік]

Дапушчэнні дыскрымінантнага аналізу такія ж, як і для MANOVA. Аналіз вельмі адчувальны да выкідаў, і памер найменшай групы павінен быць большы за колькасць прэдыктарных зменных[7].

- Многавымерная нармальнасць: незалежныя зменныя размеркаваны нармальна для кожнай групы[9][7].

- Гамагеннасць дысперсіі/каварыяцыі (гомаскедастычнасць): дысперсіі зменных аднолькавыя для ўсіх груп. Можна праверыць з дапамогай M-крытэрыя Бокса[9]. Было прапанавана, аднак, выкарыстоўваць лінейны дыскрымінантны аналіз калі каварыяцыі роўныя, і квадратычны дыскрымінантны аналіз у іншым выпадку[7].

- Мультыкалінеарнасць: прагназавальная здольнасць можа змяншацца з павелічэннем карэляцыі паміж прэдыктарнымі зменнымі[7].

- Незалежнасць: мяркуецца, што аб’екты адбіраюцца выпадкова, а значэнне адной зменнай аб’екта ўважаецца незалежным ад значэнняў гэтай зменнай для ўсіх астатніх аб’ектаў[9][7].

Была выказана здагадка, што дыскрымінантны аналіз адносна трывалы да нязначных парушэнняў гэтых дапушчэнняў[10], а таксама было паказана, што дыскрымінантны аналіз усё яшчэ можа быць надзейным пры выкарыстанні бінарных зменных (дзе часта парушаецца многавымерная нармальнасць)[11].

LDA для двух класаў[правіць | правіць зыходнік]

Разгледзім набор назіранняў (таксама званых прыкметамі, атрыбутамі, зменнымі або вымярэннямі) для кожнага аб’екта або падзеі з вядомым класам . Гэты набор аб’ектаў завецца трэніровачным наборам. Праблема класіфікацыі заключаецца ў тым, каб знайсці добры крытэрый аднясення да класа любога аб’екта з аналагічным размеркаваннем (неабавязкова з трэніровачнага набору) як функцыю толькі ад назірання [12].

LDA падыходзіць да праблемы з дапушчэннем, што функцыі шчыльнасці ўмоўнай імавернасці і адпавядаюць многавымернаму нармальнаму размеркаванню з сярэднім і матрыцай каварыяцыі і адпаведна. Згодна з гэтым дапушчэннем, аптымальнае рашэнне заключаецца ў аднясенні пунктаў да класа , калі лагарыфм суадносін праўдападобнасцяў большы за некаторае парогавае значэнне :

Без дадатковых дапушчэнняў атрыманы класіфікатар называецца квадратычным дыскрымінантным аналізам (QDA).

Аднак LDA робіць дадатковае спрашчальнае дапушчэнне гомаскедастычнасці (г.зн. што каварыяцыі класаў аднолькавыя, таму ) і што матрыцы каварыяцыі незвыродныя. У гэтым выпадку некалькі складнікаў скарачаюцца:

- , бо — сіметрычная матрыца

і прыведзены вышэй крытэрый прымае наступную форму:

для некаторай парогавай канстанты , дзе (для , што эквівалентна метаду максімальнай праўдападобнасці):

Гэта значыць, што крытэрый таго, што аб’ект належыць класу гэта функцыя лінейнай камбінацыі вядомых назіранняў.

Часта бывае карысна паглядзець на гэта з геаметрычнага пункта гледжання: крытэрый таго, што належыць класу гэта функцыя праекцыі пункта мнагамернай прасторы на вектар (такім чынам, мы ўлічваем толькі кірунак ). Іншымі словамі, назіранне належыць да , калі адпаведны знаходзіцца на пэўным баку гіперплоскасці, артаганальнай . Размяшчэнне плоскасці вызначаецца парогавым значэннем .

Правілы дыскрымінацыі[правіць | правіць зыходнік]

- Максімальная праўдападобнасць: прысвойвае групе, для якой шчыльнасць размеркавання незалежных зменных у пункце найбольшая[13].

- Баесаўскае правіла дыскрымінацыі: прысвойвае групе, якая максімізуе , дзе уяўляе сабой апрыёрную імавернасць -й групы, а адлюстроўвае шчыльнасць размеркавання незалежных зменных[13].

- Правіла лінейнага дыскрымінанта Фішэра: максімізуе суадносіны паміж і і знаходзіць лінейную камбінацыю прэдыктараў для прагназавання групы[13].

Лінейны дыскрымінант Фішэра[правіць | правіць зыходнік]

Тэрміны «лінейны дыскрымінант Фішэра» і «LDA» часта выкарыстоўваюцца як узаемазамяняльныя, хаця ў арыгінальным артыкуле[1] Фішэра апісваецца крыху іншы метад, які не робіць некаторыя дапушчэнні LDA, такія як нармальна размеркаваныя класы або роўныя класавыя каварыяцыі.

Няхай два класы назіранняў маюць сярэднія і каварыяцыі . Тады лінейная камбінацыя прыкмет будзе мець сярэдняе і дысперсію для . Фішэр вызначыў падзел паміж гэтымі двума размеркаваннямі як суадносіны дысперсіі паміж класамі да дысперсіі ўнутры класаў:

Гэтая мера ў пэўным сэнсе з’яўляецца мерай прапорцыі сігнал/шум для падзелу на групы. Можна паказаць, што максімальны падзел дасягаецца пры

- .

Калі дапушчэнні LDA выкананы, прыведзенае вышэй ураўненне эквівалентна LDA.

Звярніце ўвагу, што вектар — нармаль да дыскрымінантнай гіперплоскасці. Напрыклад, у двухмернай задачы лінія, якая лепш за ўсё падзяляе дзве групы, перпендыкулярная да .

Як правіла, пункты даных, якія трэба адрозніць, праецыруюцца на ; тады парогавае значэнне, якое лепш за ўсё падзяляе даныя, выбіраецца з аналізу аднамернага размеркавання. Агульнага правіла для парога не існуе. Аднак, калі праекцыі пунктаў з абодвух класаў маюць падобныя размеркаванні, добрым выбарам будзе гіперплоскасць паміж праекцыямі двух сярэдніх, і . У гэтым выпадку парогавае значэнне для няроўнасці можа быць знойдзена яўна:

- .

Метад Оцу звязаны з лінейным дыскрымінантам Фішэра і быў створаны для бінарызацыі гістаграмы пікселяў на выяве ў адценнях шэрага шляхам аптымальнага выбару парога паміж чорным і белым, які мінімізуе дысперсію ўнутры класаў і павялічвае дысперсію паміж класамі (адценнямі шэрага, аднесенымі для чорнага і белага класаў пікселяў).

Мнагакласавы LDA[правіць | правіць зыходнік]

У выпадку, калі існуе больш за два класы, аналіз, які выкарыстоўваецца пры вывядзенні дыскрымінанта Фішэра, можа быць пашыраны, каб знайсці падпрастору, якая б змяшчала ўсю зменлівасць класа[14]. Такое абагульненне прапанаваў Кальямпудзі Рао[15]. Дапусцім, што кожны з C класаў мае сярэдняе і аднолькавую каварыяцыю . Тады роскід паміж класамі можа быць вызначаны выбаркавай каварыяцыяй сярэдніх класаў

дзе — сярэдняе значэнне класа. Падзел класаў у кірунку у гэтым выпадку будзе зададзены як

Гэта значыць, што калі — уласны вектар , падзел S будзе роўны адпаведнаму ўласнаму значэнню.

Калі можна дыяганалізаваць, зменлівасць паміж прыкметамі будзе ўтрымлівацца ў падпрасторы, ахопленай уласнымі вектарамі, адпаведнымі найбольшым уласным значэнням C − 1 (бо мае ранг не большы за C - 1). Гэтыя ўласныя вектары як правіла выкарыстоўваюцца для скарачэння колькасці прыкмет, як у PCA. Уласныя вектары, якія адпавядаюць меншым уласным значэнням, будуць вельмі адчувальныя да дакладнага выбару навучальных даных, таму часта бывае неабходна прымяняць рэгулярызацыю.

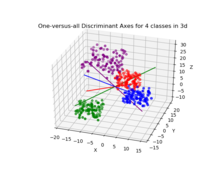

Калі патрабуецца класіфікацыя, замест зніжэння памернасці існуе шэраг альтэрнатыўных метадаў. Напрыклад, класы могуць быць згрупаваныя і стандартны дыскрымінант Фішэра або LDA выкарыстоўвацца для класіфікацыі ўнутры кожнай групы. Тыповы прыклад гэтага — метад «адзін супраць астатніх», калі аб’екты з аднаго класа дадаюцца ў адну групу, а ўсё астатняе — у другую, а пасля прымяняецца LDA. Такім чынам можна атрымаць C класіфікатараў, вынікі якіх аб’ядноўваюцца. Іншы распаўсюджаны метад — папарная класіфікацыя, пры якой новы класіфікатар ствараецца для кожнай пары класаў (агулам даючы C(C − 1)/2 класіфікатараў), з аб’яднаннем асобных класіфікатараў для атрымання канчатковай класіфікацыі.

Інкрэментны LDA[правіць | правіць зыходнік]

Тыповая рэалізацыя метаду LDA патрабуе, каб усе даныя былі даступныя загадзя. Аднак бываюць сітуацыі, калі ўвесь набор даных недаступны, а даныя паступаюць у выглядзе патоку. У гэтым выпадку пажадана, каб алгарытм LDA меў магчымасць абнаўляць параметры мадэлі шляхам назірання толькі за новымі аб’ектамі без запуску алгарытму на ўсім наборы даных. Напрыклад, у многіх выпадках працы ў рэжыме рэальнага часу, такіх як мабільная робататэхніка або распазнаванне твараў, важна абнаўляць параметры LDA, як толькі будуць даступныя новыя назіранні. Алгарытм, які можа абнаўляць параметры LDA шляхам назірання за новымі аб’ектамі называецца інкрэментным LDA, і шырока вывучаецца на працягу апошніх двух дзесяцігоддзяў[16]. Чатэрджы і Ройчаўдхуры прапанавалі інкрэментны самаарганізаваны алгарытм LDA для абнаўлення параметраў[17]. У іншай працы Дэмір і Озмехмет прапанавалі анлайн-алгарытм лакальнага навучання для паступовага абнаўлення параметраў LDA з выкарыстаннем карэкцыі памылак і правілаў навучання Хеба[18]. Пазней Аліяры і інш. вынайшлі хуткі інкрэментны алгарытм для абнаўлення параметраў LDA[16].

Выкарыстанне на практыцы[правіць | правіць зыходнік]

На практыцы сярэднія класаў і каварыяцыі невядомыя. Іх, аднак, можна ацаніць з навучальнага набору. Замест дакладнага значэння ў прыведзеных вышэй ураўненнях можа выкарыстоўвацца або ацэнка максімальнай праўдападобнасці, або ацэнка апастэрыёрнага максімуму. Нягледзячы на тое, што ацэнкі каварыяцыі можна лічыць аптымальнымі ў некаторым сэнсе, гэта не азначае, што выніковы дыскрымінант, атрыманы падстаноўкай гэтых значэнняў, з’яўляецца аптымальным, нават калі дапушчэнне нармальнасці размеркавання класаў слушнае.

Іншая складанасць у прымяненні LDA і дыскрымінанта Фішэра да рэальных даных узнікае, калі колькасць вымярэнняў кожнага аб’екту (г.зн. памернасць кожнага вектара даных) перавышае колькасць аб’ектаў у кожным класе[4]. У гэтым выпадку ацэнкі каварыяцыі не маюць поўнага рангу, і таму немагчыма знайсці адваротныя ім матрыцы. Ёсць некалькі спосабаў барацьбы з гэтым. Адным з іх з’яўляецца выкарыстанне псеўдаадваротнай матрыцы замест звычайнай адваротнай у прыведзеных вышэй формулах. Тым не менш, лепшая лікавая стабільнасць можа быць дасягнута, калі спачатку спраецыраваць праблему на падпрастору, ахопленую [19]. Іншая стратэгія для працы з невялікім памерам выбаркі заключаецца ў выкарыстанні сціснутай ацэнкі каварыяцыйнай матрыцы, якую можна выразіць матэматычна як

дзе — адзінкавая матрыца, а — «інтэнсіўнасць сціскання» або «параметр рэгулярызацыі». Гэта прыводзіць да метаду рэгулярызаванага дыскрымінантнага аналізу[20] або сціснутага дыскрымінантнага аналізу[21].

Акрамя таго, у многіх практычных выпадках лінейныя дыскрымінанты не пасуюць задачы. LDA і дыскрымінант Фішэра могуць быць пашыраны для выкарыстання ў нелінейнай класіфікацыі з дапамогай ядзернага труку. Тут арыгінальныя назіранні эфектыўна адлюстроўваюцца ў нелінейную прастору большай памернасці. Лінейная класіфікацыя ў гэтай нелінейнай прасторы тады эквівалентная нелінейнай класіфікацыі ў зыходнай прасторы. Найбольш часта выкарыстальным прыкладам гэтага ёсць ядзерны дыскрымінант Фішэра.

Параўнанне з лагістычнай рэгрэсіяй[правіць | правіць зыходнік]

Лінейны дыскрымінантны аналіз вельмі падобны да лагістычнай рэгрэсіі, і абодва алгарытмы могуць быць выкарыстаны для адказу на адны і тыя ж пытанні даследавання[9]. Лагістычная рэгрэсія не мае столькі дапушчэнняў і абмежаванняў, як дыскрымінантны аналіз. Аднак, калі дапушчэнні дыскрымінантнага аналізу выконваюцца, ён аказваецца лепшым метадам, чым лагістычная рэгрэсія[22]. У адрозненне ад лагістычнай рэгрэсіі, дыскрымінантны аналіз можна выкарыстоўваць для невялікіх памераў выбаркі. Было паказана, што пры роўных памерах выбаркі і аднастайнасці дысперсіі/каварыяцыі дыскрымінантны аналіз больш дакладны[7]. Нягледзячы на ўсе гэтыя перавагі, лагістычная рэгрэсія, тым не менш, стала больш распаўсюджанай, бо дапушчэнні дыскрымінантнага аналізу рэдка выконваюцца[8][7].

Зноскі

- ↑ а б Fisher, R. A. (1936). "The Use of Multiple Measurements in Taxonomic Problems" (PDF). Annals of Eugenics. 7 (2): 179–188. doi:10.1111/j.1469-1809.1936.tb02137.x. hdl:2440/15227.

- ↑ McLachlan, G. J. (2004). Discriminant Analysis and Statistical Pattern Recognition. Wiley Interscience. ISBN 978-0-471-69115-0. MR 1190469.

- ↑ Analyzing Quantitative Data: An Introduction for Social Researchers, Debra Wetcher-Hendricks, p.288

- ↑ а б Martinez, A. M.; Kak, A. C. (2001). "PCA versus LDA" (PDF). IEEE Transactions on Pattern Analysis and Machine Intelligence. 23 (2): 228–233. doi:10.1109/34.908974. Архіўная копія(недаступная спасылка). Архівавана з першакрыніцы 11 кастрычніка 2008. Праверана 4 красавіка 2023.Архіўная копія(недаступная спасылка). Архівавана з першакрыніцы 11 кастрычніка 2008. Праверана 4 красавіка 2023.

- ↑ Abdi, H. (2007) «Discriminant correspondence analysis.» In: N.J. Salkind (Ed.): Encyclopedia of Measurement and Statistic. Thousand Oaks (CA): Sage. pp. 270-275.

- ↑ Perriere, G.; Thioulouse, J. (2003). "Use of Correspondence Discriminant Analysis to predict the subcellular location of bacterial proteins". Computer Methods and Programs in Biomedicine. 70 (2): 99–105. doi:10.1016/s0169-2607(02)00011-1. PMID 12507786.

- ↑ а б в г д е ё ж Büyüköztürk, Ş. & Çokluk-Bökeoğlu, Ö. (2008). Discriminant function analysis: Concept and application. Egitim Arastirmalari — Eurasian Journal of Educational Research, 33, 73-92.

- ↑ а б Cohen et al. Applied Multiple Regression/Correlation Analysis for the Behavioural Sciences 3rd ed. (2003). Taylor & Francis Group.

- ↑ а б в г д Green, S.B. Salkind, N. J. & Akey, T. M. (2008). Using SPSS for Windows and Macintosh: Analyzing and understanding data. New Jersey: Prentice Hall.

- ↑ Lachenbruch, P. A. (1975). Discriminant analysis. NY: Hafner

- ↑ Klecka, William R. (1980). Discriminant analysis. Quantitative Applications in the Social Sciences Series, No. 19. Thousand Oaks, CA: Sage Publications.

- ↑ Venables, W. N.; Ripley, B. D. (2002). Modern Applied Statistics with S (4th ed.). Springer Verlag. ISBN 978-0-387-95457-8.

- ↑ а б в Hardle, W., Simar, L. (2007). Applied Multivariate Statistical Analysis. Springer Berlin Heidelberg. pp. 289—303.

- ↑ Garson, G. D. (2008). Discriminant function analysis. PA 765: Discriminant Function Analysis. Архівавана з першакрыніцы 12 сакавіка 2008. Праверана 4 сакавіка 2008. .

- ↑ Rao, R. C. (1948). "The utilization of multiple measurements in problems of biological classification". Journal of the Royal Statistical Society, Series B. 10 (2): 159–203. JSTOR 2983775.

- ↑ а б Aliyari Ghassabeh, Youness; Rudzicz, Frank; Moghaddam, Hamid Abrishami (2015-06-01). "Fast incremental LDA feature extraction". Pattern Recognition. 48 (6): 1999–2012. Bibcode:2015PatRe..48.1999A. doi:10.1016/j.patcog.2014.12.012.

- ↑ Chatterjee, C.; Roychowdhury, V.P. (1997-05-01). "On self-organizing algorithms and networks for class-separability features". IEEE Transactions on Neural Networks. 8 (3): 663–678. doi:10.1109/72.572105. ISSN 1045-9227. PMID 18255669.

- ↑ Demir, G. K.; Ozmehmet, K. (2005-03-01). "Online Local Learning Algorithms for Linear Discriminant Analysis". Pattern Recognit. Lett. 26 (4): 421–431. Bibcode:2005PaReL..26..421D. doi:10.1016/j.patrec.2004.08.005. ISSN 0167-8655.

- ↑ Yu, H.; Yang, J. (2001). "A direct LDA algorithm for high-dimensional data — with application to face recognition". Pattern Recognition. 34 (10): 2067–2069. Bibcode:2001PatRe..34.2067Y. CiteSeerX 10.1.1.70.3507. doi:10.1016/s0031-3203(00)00162-x.

- ↑ Friedman, J. H. (1989). "Regularized Discriminant Analysis" (PDF). Journal of the American Statistical Association. 84 (405): 165–175. CiteSeerX 10.1.1.382.2682. doi:10.2307/2289860. JSTOR 2289860. MR 0999675.

- ↑ Ahdesmäki, M.; Strimmer, K. (2010). "Feature selection in omics prediction problems using cat scores and false nondiscovery rate control". Annals of Applied Statistics. 4 (1): 503–519. arXiv:0903.2003. doi:10.1214/09-aoas277. S2CID 2508935.

- ↑ Trevor Hastie; Robert Tibshirani; Jerome Friedman. The Elements of Statistical Learning. Data Mining, Inference, and Prediction (second ed.). Springer. p. 128.